"Kein Wunder also, dass fast ausschließlich solche Webseiten erfolgreich sind, die an prominenter Stelle in den Suchergebnissen gelistet sind. So zeigen aktuelle Studien zum Suchverhalten folgendes:

- Die ersten 3 Plätze in den Suchergebnissen werden von 100% der Suchenden gelesen. Auf Platz 10 schauen dann nur noch 20%.

- 87% der Klicks erfolgen auf natürliche Suchergebnisse und nicht etwa auf Adwords

Diese Erkenntnisse sind allemal interessant. Sie sind aber noch viel mehr. Für kommerzielle Webprojekte enthalten sie den Schlüssel zum Überleben. Denn wer Suchmaschinen-Optimierung mit gekauften Suchbegriffen gleichsetzt oder auf die Optimierung seiner Seiten verzichtet, wird seine Internetseite kaum erfolgreich gestalten können." [2]

Wie gewichtet jedoch eine Suchmaschine die Menge an Resultaten, was ist dieser Google PageRank, welche Rolle spielt er für mich bzw. für die Optimierung meiner Seite an sich und welche Faktoren spielen eventuell zudem eine Rolle?

1.1 Zielsetzung

Die folgende Ausarbeitung soll ein Grundverständnis des PageRank Algorithmus ermöglichen und die daraus resultierenden Schlussfolgerungen aufzeigen. Zudem wird, um auf die zukünftigen Trends eingehen zu können, ebenfalls der Google-Algorithmus beleuchtet.

1.2 Struktur dieser Arbeit

Im ersten Teil dieser Arbeit wird die Entwicklung des PageRank-Algorithmus erläutert. Dann folgt eine Erklärung die die Berechnung durch einige Rechenbeispiele darstellt. Der Teil endet mit den daraus resultierenden Schlussfolgerungen. Im zweiten Teil wird der PageRank-Algorithmus um weitere Bewertungsfaktoren erweitert. Dabei werden nur einige wenige wichtige Faktoren beleuchtet. Eine vollständige Auflistung erlaubt der Umfang dieser Arbeit nicht. Die Arbeit schließt mit einem Fazit ab. Die Arbeit entstand im Rahmen meines berufsbegleitenden Studiums an der FHDW Bielefeld.

2. Google PageRank

2.1 Historische Entwicklung

Im Laufe der Zeit hat es viele Versuche gegeben automatische Verfahren zur Bewertung von Dokumenten zu implementieren. Ein wichtiger Bestandteil der Analyse war natürlich das Vorkommen des Suchwortes. Dieses reichte jedoch schnell, bei exponentiell steigenden Inhalten im Web, nicht mehr um gute und relevante Suchergebnisse zu liefern. Zudem musste ein sich in den Anfängen von Suchmaschinen noch nicht abzeichnendes Bild von Manipulationen der Inhalte gelöst werden: "However, the Web of 1997 is quite different. Anyone who has used a search engine recently, can readily testify that the completeness of the index is not the only factor in the quality of search results. Junk results often wash out any results that a user is interested in. [3]

Lawrence Page und Sergey Brin nahmen sich diesem Problem an und entwickelten ganz nebenbei in ihrem Studium die Suchmaschine Google. Der ursprüngliche Erfolg von Google ist, neben dem klaren und einfachen Interface, somit auf den Einsatz eines neuen Algorithmus zurückzuführen: Dem PageRank. Dieser hat seinen Namen, obwohl es nahe liegend wäre, nicht vom englischen Wort "Page" sondern vom Nachnamen seines Schöpfers Lawrence Page. [4] Zum Page-Rank-Verfahren veröffentlichten beide eine wissenschaftliche Arbeit mit dem Titel "The Anatomy of a Large-Scale Hypertextual Web Search Engine".

2.2 Konzept

Zu den Grundzügen von Google gehörte schon frühzeitig die Analyse von Linkstrukturen innerhalb und außerhalb der Webseite. So beschäftigen sich die beiden Urbegründer von Google bereits 1997 mit dem Thema. Ihr Ziel war es dabei die Qualität der Suchergebnisse zu verbessern (Improved Search Quality). [5]

"The citation (link) graph of the web is an important resource that has largely gone unused in existing web search engines. We have created maps containing as many as 518 million of these hyperlinks, a signicant sample of the total. These maps allow rapid calculation of a web page's "PageRank", an objective measure of its citation importance that corresponds well with people's subjective idea of importance. Because of this correspondence, PageRank is an excellent way to prioritize the results of web keyword searches. For most popular subjects, a simple text matching search that is restricted to web page titles performs admirably when PageRank prioritizes the results [..] For the type of full text searches in the main Google system, PageRank also helps a great deal." [6]

Das entscheidende Konzept für die Relevanz von Dokumenten besteht also in der bis dato von anderen Suchmaschinen ungenutzten Linkstruktur der Webseiten untereinander. Die Idee besteht darin das, sobald eine Seite auf eine andere verweist, dies als Empfehlung verstanden wird. Dabei wird davon ausgegangen, dass je häuger eine Seite von anderen verlinkt wird, desto höher ihre Relevanz im Web ist.

2.3 Berechnung

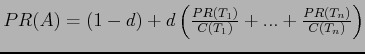

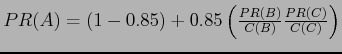

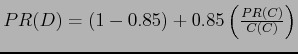

Die Berechnung des PageRank erfolgt durch folgende Formel:

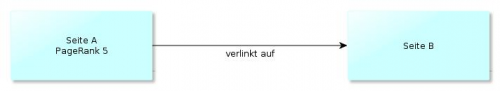

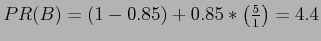

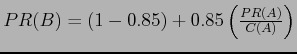

Dabei sei PR(A) der PageRank der Seite A. PR(T1) beschreibt den PageRank der Seite T1 und C(T1) die Anzahl der aller Links der Seite T1. Der Dämpfungsfaktor sei durch die Variable d repräsentiert. Die Formel beschreibt somit einen iterativen Algorithmus. Das heißt eine Methode sich der Lösung eines Rechenproblems schrittweise, durch wiederholendes Anwenden desselben Verfahrens anzunähern. Eine Eigenart dieser Verfahren ist es, dass der Startwert, mit dem begonnen wird, keine Rolle spielt. Er hat ausschließlich Einfluss auf die Anzahl der durchzuführenden Wiederholungen. [7] Google selbst gab 1997 an den PageRank aller Seiten im Web mit einer mittleren Workstation in ein paar Stunden berechnen zu können: "Also, a PageRank for 26 million web pages can be computed in a few hours on a medium size workstation. There are many other details which are beyond the scope of this paper." [8] Zur Berechnung des PageRank wird also jede Seite mit einem beliebigen Startwert initialisiert. Dann wird der PageRank ermittelt in dem der PageRank der Seiten, die auf die zu berechnende Seite verweisen, aus dem Lauf zuvor genommen und durch die Anzahl aller Links der Seite dividiert wird. Diese Schritte werden so oft wiederholt bis der PageRank aller Seiten konvergiert und sich somit ausreichend angenähert hat. Nun hat das PageRank-Konzept, im Gegensatz zum ausschließlichem Zählen der eingehenden Links eines Dokumentes, um dessen Rang zu ermitteln (=Link-Popularity), den Vorteil, dass es die Wahrscheinlichkeit, dass ein typischer Benutzer einem Link folgt, mit einbezieht. Dieser typische Benutzer wird als "Random Surfer" bezeichnet. Diese Wahrscheinlichkeit wird als Faktor "d", oder auch Dämpfungsfaktor ausgedrückt. Der Dämpfungsfaktor ist der Grund dafür, weswegen der PageRank von Seite A mit einem ausgehenden Link nicht vollständig an Seite B weitergegeben wird. In der Praxis wird davon ausgegangen, dass der Dämpfungsfaktor 0,85 beträgt. Somit werden, unter der Annahme, dass die verlinkende Seite A nur einen Link besitzt, ausschließlich 85% plus der Untergrenze des PageRank an die verlinkte Seite B weitergegeben. Die PageRank Untergrenze ist als 1-d definiert. Dies lässt sich wie folgt darstellen:

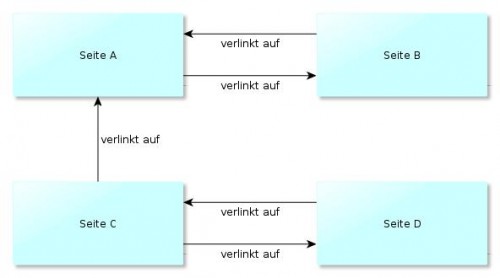

Zu erkennen ist das, wie erwähnt, Seite A ausschlieÿlich auf Seite B verlinkt. Daraus

lässt sich der PageRank von Seite B wie folgt ermitteln:

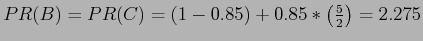

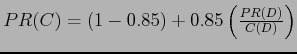

Natürlich ist es sehr unwahrscheinlich, dass eine Seite ausschließlich auf eine einzelne Seite verlinkt. In der Regel verlinken Seiten auf mehrere andere Seiten - das hat natürlich eine Auswirkung auf den PageRank. Wie in Abbildung 2 zu erkennen ist verlinkt Seite A nun auf Seite B und auf Seite C. Der PageRank der beiden Seiten errechnet sich demnach wie folgt:

Bei einem Vergleich zum obigen Beispiel fällt auf, dass sich der vererbte PageRank beinahe halbiert hat. Daraus lässt sich folgern, dass jeder zusätzliche Link von Seite A eine mitunter starke Auswirkung auf den PageRank von Seite B und C hat. Dies resultiert aus dem Verhältnis von PR(Tn )zu C(Tn ), welches ausdrückt, dass bei einer zunehmenden Anzahl von Links die Bedeutung jedes einzelnen Links für die verlinkte Seite abnimmt. Nun ist das Web in der Realität nicht, wie in diesen Beispielen, hierarchisch organisiert, sondern folgt der Struktur eines Netzes. Das bedeutet, dass theoretisch jede Seite einen Link zu jeder anderen Seiten setzen könnte.

| Seite | Links eingehend von | Links gesamt = C(Seite) |

| A | B,C | 1 |

| B | A | 1 |

| C | D | 2 |

| D | C | 1 |

| Iterationen | PageRank(A) | PageRank(B) | PageRank(C) | PageRank(D) |

| 0 | 1,000 | 1,000 | 1,000 | 1,000 |

| 1 | 1,4300 | 0,000 | 0,000 | 0,000 |

| 2 | 0,000 | 1,3613 | 0,6388 | 0,5750 |

| 3 | 1,5785 | 1,3613 | 0,6388 | 0,4215 |

| 4 | 1,5785 | 1,4918 | 0,5082 | 0,4215 |

| 5 | 1,6340 | 1,4918 | 0,5082 | 0,3660 |

| 6 | 1,6340 | 1,5389 | 0,4611 | 0,3660 |

| ... | ... | ... | ... | ... |

| ... | ... | ... | ... | ... |

| 24 | 1,6654 | 1,5656 | 0,4344 | 0,3346 |

| 25 | 1,6654 | 1,5656 | 0,4344 | 0,3346 |

2.4 Schlussfolgerungen

Eingehende und ausgehende Links haben einen Einuss auf den PageRank der einzelnen Seiten. "Jeder eingehende Link erhöht den PageRank der Seite. In gewisser Weise repräsentieren diese Links die Meinung anderer Seitenbetreiber zur eigenen Seite. Denn normalerweise wird ein Link auf eine Seite gesetzt, wenn diese auf irgendeine Weise für den verweisenden Seitenbetreiber interessant oder relevant ist." [10] Es hilft jedoch wenig die eigene Seite in z.B. groÿe Linkkataloge einzutragen - hier tendiert, durch die hohe Anzahl an ausgehenden Links, selbst bei einem hohen PageRank des Linkkatalogs der Effekt gegen Null. In der Praxis besteht ein Internetauftritt aus mehreren einzelnen Seiten, die jeweils einen einzelnen PageRank besitzen. So kann es vorkommen, dass, falls eine Unterseite des Internetauftritts deutlich häuger verlinkt ist als die Startseite, diese einen höheren PageRank besitzt. Der PageRank eines Internetauftritts ist also, rein rechnerisch, die Summe aller PageRanks seiner Seiten. Das bedeutet, dass jeder ausgehende Link, auf Grund des Verhältnisses von PageRank zu Seiten, in Summe den PageRank des eigenen Internetauftritts senkt. Die Schlussfolgerungen nun gar keine externen Links zu setzen widerspricht jedoch den Grundprinzipien des World Wide Web. [11] Zudem kann davon ausgegangen werden, dass Google einen qualitativ hochwertigen externen Link eventuell auch in die Beurteilung der Seite mit einfließen lässt, die den Link gesetzt hat. [12]3 Wohin geht der Trend?

Immer wieder wird der PageRank als das absolute Messinstrument zur Suchmaschinenoptimierung genannt. Doch wie wichtig ist der PageRank wirklich? Welche Faktoren spielen zusätzlich eine Rolle und wie stark sind diese, im Vergleich zum PageRank, zu gewichten? Zu den Anfangszeiten von Google und dem Beginn der kommerziellen Suchmaschinenoptimierung war der PageRank noch eines der elementarsten Werkzeuge, das zum Erfolg führte. Diese Zeiten haben sich jedoch weitgehend verändert. So gehen die Tendenzen zur Zeit immer weiter Richtung anderer Faktoren - der PageRank hat als Faktor der die Position in einem Suchergebnis angibt, seine besten Zeiten hinter sich. Lange Zeit wurde der PageRank trotzdem als Messinstrument verstanden, das die geleistete Arbeit des Suchmaschinenoptimierers widerspiegelt und zeitnah abgelesen werden konnte. Das war ein Irrtum wie folgende Tabelle der bisherigen veröffentlichen PageRank-Updates durch Google zeigt:| Update am | Tage seit dem vorherigen Update |

| 03.04.2010 | 92 |

| 31.12.2009 | 62 |

| 30.10.2009 | 128 |

| 24.06.2009 | 28 |

| 27.05.2009 | 55 |

| 02.04.2009 | 91 |

| 31.12.2008 | 94 |

| 28.09.2008 | 64 |

| 26.07.2008 | 8 |